起猛了,腾讯元宝接入DeepSeek了。

起猛了,腾讯元宝接入DeepSeek了。这应该是我知道的第一家有自己大模型的大厂,第一次在面向C端的AI助手应用中,第一次接入DeepSeek R1。这个意义影响还是非常深远的,腾讯在AI这一步上,好像走的格外的开放,从之前的批量开源MoE、混元绘图模型、混元视频模型、混元3D模型,还有今天这神之一手接入DeepSeek R1。

这应该是我知道的第一家有自己大模型的大厂,第一次在面向C端的AI助手应用中,第一次接入DeepSeek R1。这个意义影响还是非常深远的,腾讯在AI这一步上,好像走的格外的开放,从之前的批量开源MoE、混元绘图模型、混元视频模型、混元3D模型,还有今天这神之一手接入DeepSeek R1。

整个春节假期,我眼睁睁看着 DeepSeek 从“全民狂欢”变成“全民卡顿”——官网十问九崩,还有谁没被“服务器正忙,请稍后重试”的提示,搞崩溃过。

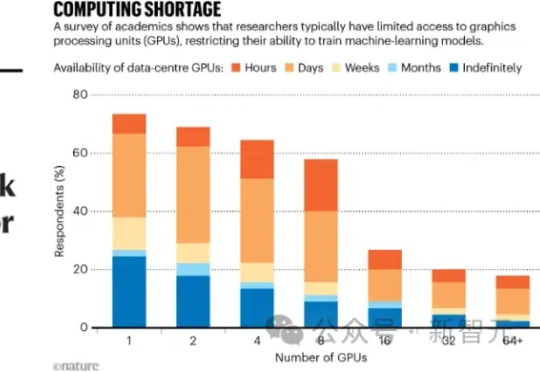

梁文峰说,钱从来都不是问题,唯一担心的是缺算力。不过,基于国产昇腾算力的DeepSeek R1系列推理API,性能已经直接对标高端GPU了!而且,华为已经率先携手国内15所头部高校,打造出了独一份的科教创新卓越/孵化中心,通过产教融合、科教融汇破解高校科研的算力困局。

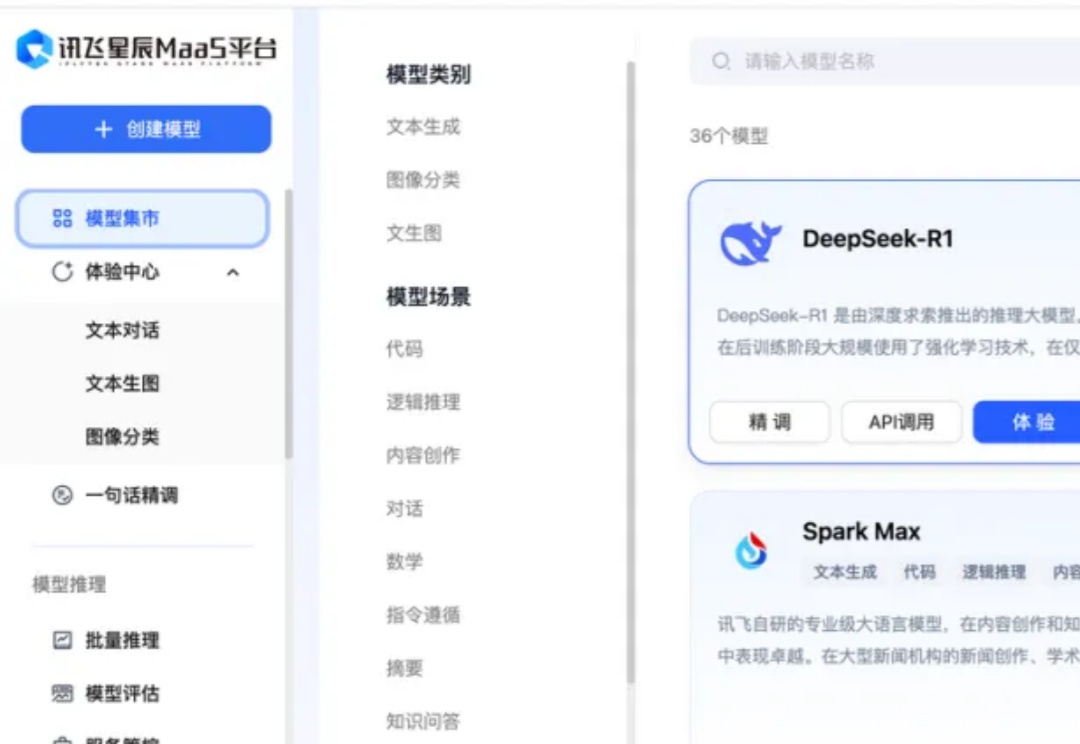

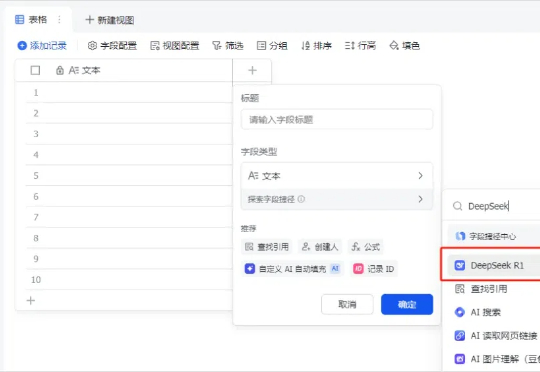

用了两天接入了DeepSeek R1的飞书,坦率的讲,我已经被彻底折服了,今天,我必须要写一篇文章安利一下。故事是这样的。飞书的多维表格,在前天下午接入了满血版的DeepSeek R1。

还在为 DeepSeek R1 官网的卡顿抓狂?无问芯穹大模型服务平台现已上线满血版 DeepSeek-R1、V3,无需邀请即可免费用 Token!另有异构算力鼎力相助,支持通过 Infini-AI 异构云平台一键获取 DeepSeek 系列模型与多元异构自主算力服务。

DeepSeek 在海内外搅起的惊涛巨浪,余波仍在汹涌。当中国大模型撕开硅谷的防线之后,在预设中总是落后半拍的中国 AI 军团,这次竟完成了一次反向技术输出,引发了全球范围内复现 DeepSeek 的热潮。

近日,来自香港科技大学、南洋理工大学等机构的研究团队最新成果让这一设想成为现实。他们提出的 SelfDefend 框架,让大语言模型首次拥有了真正意义上的 ' 自卫能力 ',能够有效识别和抵御各类越狱攻击,同时保持极低的响应延迟。

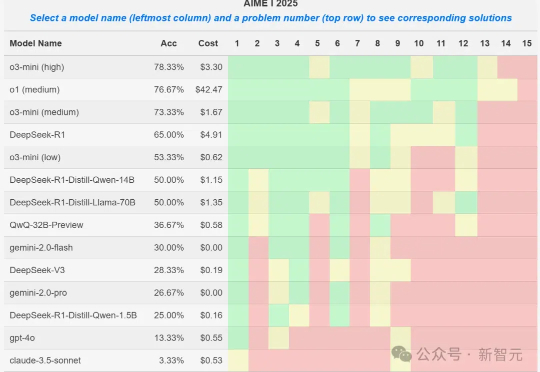

就在刚刚,AIME 2025 I数学竞赛的大模型参赛结果出炉,o3-mini取得78%的最好成绩,DeepSeek R1拿到了65%,取得第四名。然而一位教授却发现,某些1.5B小模型竟也能拿到50%,莫非真的存在数据集污染?

2月8日,昆仑万维旗下「天工AI」正式推出PC版重大更新——上线“DeepSeek R1 + 联网搜索”功能。这一全新升级,不仅解决了用户长期以来关注的DeepSeek联网功能无法使用的问题,还优化了R1版本偶尔崩溃的困扰,为用户带来更加稳定、高效、智能的AI体验。

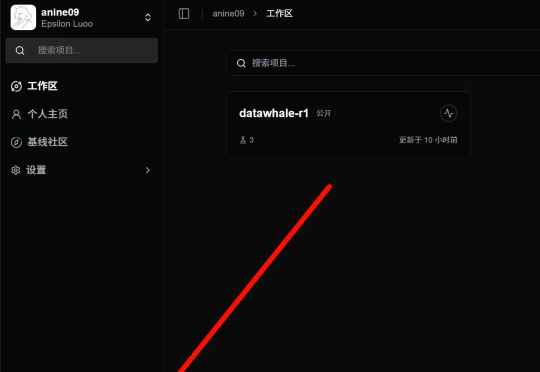

各位同学好,我是来自 Unlock-DeepSeek 开源项目团队的骆师傅。先说结论,我们(Datawhale X 似然实验室)使用 3 张 A800(80G) 计算卡,花了 20 小时训练时间,做出了可能是国内首批 DeepSeek R1 Zero 的中文复现版本,我们把它叫做 Datawhale-R1,用于 R1 Zero 复现教学。